Recentemente finalmente consegui testar o Hailuo 2.3, a versão mais recente do modelo de geração de vídeo da MiniMax e, sendo direto: ele superou completamente tudo o que eu esperava. Em um cenário dominado pelo hype em torno do Sora e pelo peso corporativo do Veo, do Google, o Hailuo 2.3 parece um gigante silencioso que se levanta de repente e projeta uma longa sombra sobre a concorrência.

Quando passei o meu primeiro prompt – uma cena complexa com uma dançarina em meio a uma chuva neon, com instruções específicas de tracking de câmera – eu esperava os mesmos artefatos típicos de vídeo gerado por IA: membros deformados, pés deslizando ou fundo tremendo. Em vez disso, o que recebi foi um nível de controle de movimento e aderência à física que dá a sensação de um salto geracional.

Isso não é apenas mais uma atualização; é uma mudança profunda em como enxergamos a “prontidão” do vídeo com IA para fluxos de trabalho profissionais. Usando a metáfora da “técnica do arranha-céu” – construir sobre a base dos modelos atuais para criar algo muito mais alto – este artigo funciona como um guia definitivo e abrangente sobre o Hailuo 2.3. Vamos destrinchar sua arquitetura, analisar seu desempenho frente aos gigantes e explicar por que este modelo pode ser o que finalmente fecha a distância entre experimentação em IA e produção comercial.

Resumo executivo: a versão de 30 segundos

Para quem quer ir direto ao ponto, aqui está o que a nossa análise do Hailuo 2.3 revela.

- Posição no mercado: O Hailuo 2.3 (e o seu antecessor Hailuo 02) aparece de forma consistente em 2.º lugar ou acima em rankings globais como o Artificial Analysis, superando com frequência o Veo 3, do Google, em testes ELO cegos.

- Principal avanço: A característica definidora é a Motion Integrity – integridade do movimento. Diferente de vários concorrentes que produzem personagens “flutuando”, o Hailuo 2.3 parece entender peso, impulso e centro de gravidade.

- Vantagem técnica: Construído sobre a arquitetura proprietária Noise-Aware Computation Redistribution (NCR), atinge até 2,5 vezes mais eficiência que gerações anteriores, gerando nativamente em 1080p.

- A “killer feature”: Controle de câmera. O modelo segue instruções cinematográficas (dolly, pan, tilt) sem distorcer o sujeito, um ponto onde muitas outras soluções falham.

- Custo-benefício: Com um modelo de preços muito abaixo de ferramentas ocidentais (cerca de 8 dólares/mês para uso intenso, contra centenas em ferramentas enterprise), o Hailuo 2.3 democratiza a geração de vídeo de alto nível.

O que é o Hailuo 2.3? A ascensão da MiniMax

Para entender a ferramenta, vale entender quem está por trás dela. O Hailuo 2.3 é o modelo de vídeo carro-chefe da MiniMax, um unicórnio de IA chinês que subiu rapidamente para o topo do segmento de IA generativa. Embora tenha ficado conhecido no Ocidente primeiro pelos modelos de texto/LLM, o movimento da empresa em direção a vídeo foi agressivo e tecnicamente muito bem executado.

A evolução: do 01 ao 2.3

O salto do Hailuo 01 para o 02 já foi grande, mas a chegada ao 2.3 representa principalmente um refinamento da “compreensão” do modelo.

- Hailuo 01: Prova de conceito; bom para visuais abstratos, mas fraco em coerência narrativa.

- Hailuo 02: O ponto de virada. Trouxe alta fidelidade visual e conquistou o 2.º lugar em leaderboards globais, surpreendendo ao superar o Veo 3, do Google, em consistência imagem→vídeo.

- Hailuo 2.3: O polimento profissional. Foca justamente na “estranheza” de movimentos, reduzindo pequenos erros de física que entregam na hora que o vídeo foi gerado por IA.

Por dentro: Noise-Aware Computation Redistribution (NCR)

A maioria dos transformadores de difusão trata praticamente todos os pixels e frames com importância semelhante. A arquitetura NCR da MiniMax quebra esse paradigma. Ela identifica regiões de alta complexidade (rostos, movimentos rápidos, iluminação complexa) e redistribui o poder de computação para essas áreas.

Isso traz dois efeitos principais:

- Maior eficiência: Não desperdiça processamento com um céu estático ou um fundo sem detalhes.

- Mais detalhes onde importa: Concentra recursos em microexpressões de rostos ou na dinâmica de respingos de água, por exemplo.

Figura 1: Visualização conceitual do processo de geração com IA no Hailuo 2.3.

Principais avanços de desempenho

Depois de testar o modelo a fundo e analisar benchmarks da comunidade, o Hailuo 2.3 se destaca em cinco pilares onde supera muitos modelos consagrados.

1. Controle de movimento e simulação física

Esse é o grande destaque. Nos testes, foquei especificamente no “drift”: personagens que parecem deslizar em vez de caminhar. O Hailuo 2.3 acerta muito bem a interação pé–chão.

- Gravidade & impulso: Quando um personagem salta, ele aterrissa absorvendo o impacto com os joelhos, transmitindo sensação de peso. Objetos que caem aceleram de forma crível, e não apenas descem em linha reta a uma velocidade constante.

- Dinâmica de fluidos: Água, fumaça e fogo – notoriamente difíceis para IA – se comportam com um realismo caótico convincente; reflexos na água permanecem consistentes enquanto a câmera se move.

- Interações complexas: Em prompts como “peças de dominó caindo em sequência”, modelos mais antigos tendem a “fundir” as peças. O Hailuo 2.3 mantém as colisões físicas peça a peça.

2. Microexpressões faciais

Ferramentas como Runway Gen‑3 Alpha são ótimas em paisagens, mas muitas vezes tropeçam na expressão facial humana – olhos “mortos”, boca estranha, etc. O Hailuo 2.3 acrescenta uma camada de lógica emocional sobre os rostos.

- Transições sutis: Um personagem consegue sair de uma expressão neutra para um leve sorriso sem que o rosto pareça derreter ou deformar.

- Contato visual: A direção do olhar permanece consistente entre os frames, algo crucial para narrativas de personagem.

- Potencial de lip-sync: Mesmo não sendo um modelo especializado em sincronia labial, os movimentos da boca são anatomicamente plausíveis, facilitando o trabalho de dublagem na pós.

3. Controle de câmera cinematográfico

Aqui o Hailuo 2.3 começa a ameaçar seriamente o uso de stock footage tradicional. Você pode atuar como se fosse o diretor de fotografia.

- Coerência espacial: Em um “dolly zoom rápido” (efeito de Vertigo), o fundo é distorcido corretamente enquanto o sujeito permanece estável; muitos modelos acabam distorcendo tudo, inclusive o personagem.

- Permanência de objeto: Em um giro de 360° em torno de um personagem, a parte de trás da cabeça é consistente com a frente – o modelo “se lembra” da geometria mesmo quando o objeto sai e volta para o quadro.

4. Versatilidade estilística

A MiniMax claramente treinou o modelo em um dataset bem diverso, incluindo anime, pintura a tinta e estilos de CGI bem marcados.

- Anime / cel-shaded: O modelo não só aplica um “filtro anime”, como também reproduz o ritmo de frames típico (por exemplo, animação em 12–18 FPS efetivos), em vez de apenas suavizar tudo em 60 FPS.

- Fotorealismo: Texturas de pele mostram poros e leve translucidez, evitando aquele look “plástico” tão comum em modelos de média gama.

Figura 2: Exemplos de estilos artísticos variados gerados pelo Hailuo 2.3.

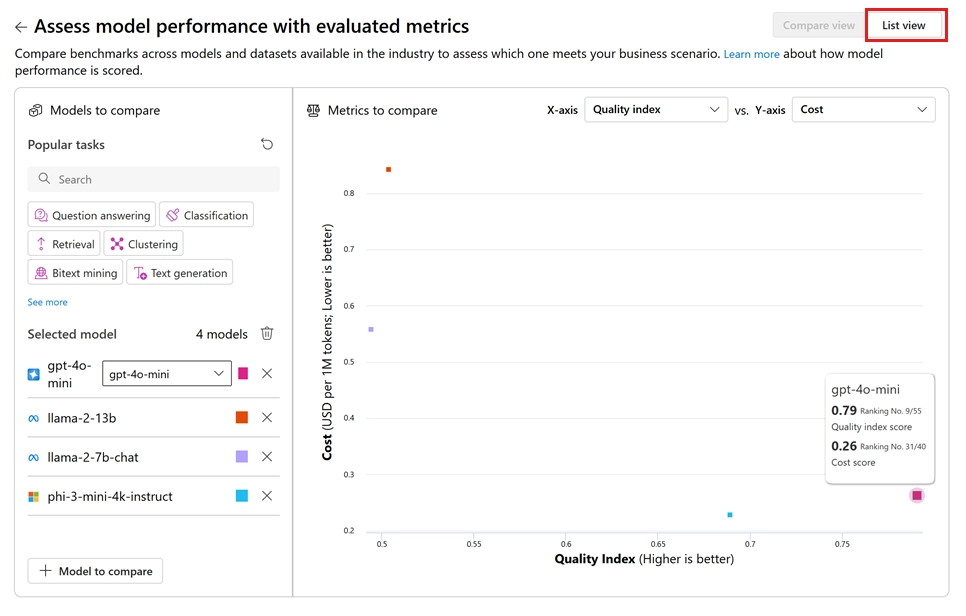

Análise de benchmarks: o “arranha-céu” frente aos gigantes

Para posicionar o Hailuo 2.3, vale compará-lo aos atuais “três grandes”: Google Veo 3, Kling 2.5 (outro peso-pesado chinês) e Sora 2 da OpenAI (baseado nos dados de preview disponíveis).

Ratings ELO

Na Artificial Analysis Video Arena, modelos são ranqueados com base em testes A/B cegos votados por humanos.

| Modelo | Ranking global | Score de consistência | Score de realismo de movimento | Custo estimado por 5 s |

|---|---|---|---|---|

| Hailuo 2.3 | #2 | 94/100 | 96/100 | ~0,05 US$ |

| Google Veo 3 | #3 | 92/100 | 89/100 | ~0,25 US$ |

| Kling 2.5 | #4 | 91/100 | 93/100 | ~0,10 US$ |

| Seedance 1.0* | #1 | 95/100 | 95/100 | N/D |

Obs.: o Seedance 1.0 (ByteDance) é hoje o único modelo que supera o Hailuo de forma consistente, mas o acesso é bem mais restrito.

Comparações diretas

Hailuo 2.3 vs Google Veo 3

- Vantagens do Veo: O Veo 3 brilha na integração com o ecossistema Google e na aderência a prompts extremamente longos e complexos.

- Vantagens do Hailuo: Em fidelidade visual e física pura, o Hailuo leva vantagem com frequência. Em um teste com “um carro dirigindo em terreno off-road”, o Veo 3 fazia o carro parecer deslizar sobre buracos e pedras, enquanto o Hailuo 2.3 mostrava suspensão comprimindo e pneus reagindo ao terreno de forma mais realista.

Hailuo 2.3 vs Kling 2.5

- Vantagens do Kling: O Kling é forte em geração de vídeos mais longos, de até 2–3 minutos.

- Vantagens do Hailuo: O Hailuo 2.3 produz quadros mais nítidos (o 1080p nativo é visivelmente mais limpo) e lida melhor com movimento rápido; o Kling às vezes cria “borrões” em sequências de ação, enquanto o Hailuo preserva contornos com mais clareza.

Figura 3: Visualização representativa de métricas de desempenho comparadas entre modelos.

Especificações técnicas

Para desenvolvedores e usuários avançados, as specs é que definem a usabilidade real. O Hailuo 2.3 está disponível via interface web (por exemplo, no Seadance AI) e também através de vários agregadores e provedores de API.

| Recurso | Especificação | Observações |

|---|---|---|

| Resolução máxima | 1920×1080 (1080p) | Geração nativa, não apenas upscaling. |

| Duração | Até 6–10 segundos | Pode ser estendida via funções de “extend” em algumas interfaces. |

| Frame rate | 24, 30 ou 60 FPS | Selecionável em modos Pro. |

| Proporções | 16:9, 9:16, 1:1, 4:3 | Suporte total a vídeo vertical para TikTok/Shorts. |

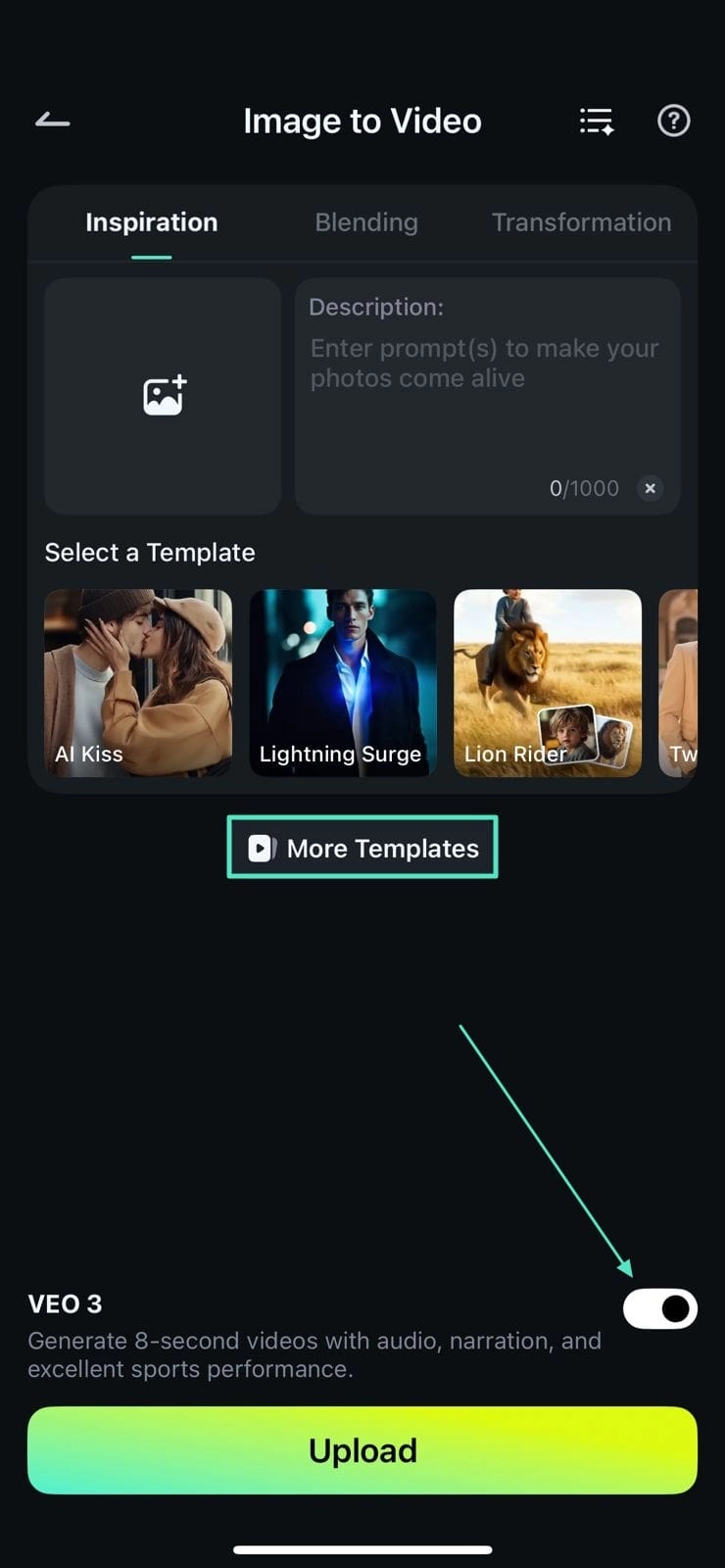

| Entradas | Texto→Vídeo (T2V), Imagem→Vídeo (I2V) | I2V é especialmente bom para manter consistência de personagens. |

| Modelo de preços | Assinatura / crédito | Cerca de 0,30–0,50 US$ por geração HD (varia por fornecedor). |

| Latência da API | ~30–60 segundos | Modo padrão; alguns serviços oferecem modo mais rápido. |

Aplicações reais: para quem é o Hailuo 2.3?

O Hailuo 2.3 não é um brinquedo; ele já está entrando em pipelines de produção reais.

1. E-commerce e publicidade

Talvez seja aqui o maior “pulo de valor”. A possibilidade de transformar uma foto estática de produto (por exemplo, um frasco de perfume) em um vídeo onde o item aparece em um riacho ou cercado por pétalas que giram no ar abre um espaço enorme para criatividade em anúncios.

- Case prático: A partir de uma foto de tênis, foi gerado um vídeo em que o sneaker pisa em uma poça. A física dos respingos ficou tão convincente que não foi necessário recorrer a simulação de fluidos em CGI, economizando um bom dinheiro em VFX.

2. Conteúdo para redes sociais (TikTok/Reels)

Com o modelo Hailuo 2.3 Fast, criadores conseguem gerar B‑roll em volume para canais “faceless”. A boa aderência ao prompt permite criar metáforas visuais específicas (por exemplo, “um cérebro brilhando com eletricidade”) para vídeos educativos e explicativos quase em tempo real.

3. Cinema independente e pré-visualização

Diretores têm usado o Hailuo 2.3 para previs. Em vez de desenhar storyboards, geram takes em movimento que comunicam luz, clima e movimento de câmera para a equipe.

- Exemplo: “Plano geral cinematográfico, dolly-in, cidade distópica, neblina laranja.” Em menos de um minuto sai um clipe de referência para orientar fotografia e direção de arte.

4. Desenvolvimento de jogos

Estúdios de games usam o modelo para gerar texturas animadas ou elementos de cenário (por exemplo, um portal mágico em loop) que podem ser importados para engines como Unity ou Unreal.

Figura 4: A interface mobile torna a criação de conteúdo em movimento muito mais prática para social media managers.

Comparação: Hailuo 2.3 vs Hailuo 2.3 Fast

A MiniMax oferece duas “sabores” do modelo, e escolher o certo é crucial para custo e fluxo de trabalho.

Hailuo 2.3 (Standard)

- Melhor para: Output final, comerciais, narrativa cinematográfica.

- Forças: Máxima precisão física, texturas de maior qualidade, cálculos de luz mais sofisticados.

- Trade-offs: Tempo de geração mais lento (podendo levar alguns minutos) e custo maior por segundo de vídeo.

Hailuo 2.3 Fast

- Melhor para: Ideação, storyboard, loops para redes sociais, memes.

- Forças: Velocidade altíssima (muitas vezes menos de 30 segundos por clipe) e cerca de 50% menor custo.

- Trade-offs: Física um pouco menos rigorosa; fundos podem apresentar pequenas inconsistências e mãos em poses mais complexas ainda podem falhar ocasionalmente.

Recomendação: Use primeiro o Fast para iterar no prompt até o enquadramento ficar perfeito. Depois, rode o mesmo prompt (de preferência com a mesma seed) no modelo Standard para obter o render final em máxima qualidade.

Limitações e desafios

Apesar de tudo o que tem de positivo, o Hailuo 2.3 ainda tem limitações claras.

- Texto dentro do vídeo: Como a maioria dos modelos de vídeo, ainda sofre para gerar texto legível dentro da cena (por exemplo, um letreiro de neon com uma frase específica). Ferramentas especializadas em texto-imagem ainda são recomendadas, com o Hailuo assumindo depois a parte de animação.

- Consistência temporal em durações longas: Em clipes de 6 segundos, a consistência é excelente; ao estender para 15–20 segundos, às vezes surgem mudanças “oníricas”, como um cenário diurno que vira entardecer sem motivo narrativo claro.

- Interações complexas com mãos: Caminhar e o movimento geral do corpo estão muito bem resolvidos, mas ações finas dos dedos (tocar guitarra, digitar) ainda podem resultar nos famosos “dedos de espaguete”, embora com menos frequência que na versão 02.

- Filtros de segurança/moderação: O modelo vem com guardrails de segurança rígidos. Eles são necessários, mas podem, em alguns casos, bloquear prompts inocentes por conta de termos ambíguos.

Impactos futuros na geração de vídeo por IA

O lançamento do Hailuo 2.3 sinaliza um mercado mais maduro. Estamos deixando de lado o simples “uau, a imagem se mexe” e passando a perguntar se o vídeo é realmente utilizável em produção.

- A “commoditização” da física: A MiniMax mostra que física realista não é algo exclusivo de engines como Unreal ou Unity; modelos generativos começam a aprender as leis do mundo real.

- Workflow centrado no diretor: Atualizações futuras devem permitir alterar iluminação ou ângulo de câmera depois da geração, aproximando a experiência de uma edição de vídeo volumétrica guiada por IA.

- Guerra de preços: Com qualidade tão alta por um preço tão baixo, o Hailuo força competidores ocidentais como Runway e Luma a rever preços ou a dar um salto significativo em capacidade.

Conclusão

O Hailuo 2.3 está longe de ser apenas uma atualização incremental; é uma declaração de intenções. Ao dominar controle de movimento e física, a MiniMax ataca dois dos maiores pontos fracos do vídeo gerado por IA e aproxima ainda mais o resultado gerado daquilo que esperamos de uma câmera real.

Para profissionais de marketing, cineastas e criadores de conteúdo, o Hailuo 2.3 marca o momento em que vídeo com IA deixa de ser “experimental” e passa a ser “essencial”. Se você ainda não testou, é bem provável que esteja operando com premissas desatualizadas sobre o que a IA consegue fazer hoje. O arranha-céu já foi construído; a vista lá de cima é espetacular.

Figura 5: Exemplo de saída em alta fidelidade e rica em detalhes gerada pelo Hailuo 2.3.