Je viens tout juste de mettre la main sur Hailuo 2.3, la dernière itération du modèle de génération vidéo de MiniMax, et pour le dire sans détour : il a complètement dépassé mes attentes. Dans un paysage dominé par le battage autour de Sora et le poids des géants comme Google avec Veo, Hailuo 2.3 ressemble à un géant silencieux qui se lève soudainement et projette une longue ombre sur la concurrence.

Pour mon premier prompt – une scène complexe avec une danseuse sous une pluie néon, avec des instructions précises de suivi caméra – je m’attendais aux artefacts habituels des vidéos IA : membres déformés, pieds qui glissent, arrière-plans instables. À la place, j’ai obtenu un niveau de contrôle du mouvement et de respect de la physique qui donne l’impression d’un véritable saut de génération.

Ce n’est pas juste une mise à jour de plus ; c’est un changement de paradigme dans notre perception de la « maturité » de la vidéo IA pour les workflows professionnels. En suivant une sorte de « technique du gratte-ciel » – construire sur les bases des modèles existants pour créer quelque chose de nettement supérieur – cet article se veut le guide de référence sur Hailuo 2.3. Nous allons décortiquer son architecture, analyser ses performances face aux géants du secteur et explorer pourquoi ce modèle pourrait être celui qui fait enfin le pont entre expérimentation IA et production commerciale.

Executive Summary : le brief en 30 secondes

Pour celles et ceux qui veulent aller droit au but, voici l’essentiel de notre analyse de Hailuo 2.3.

- Position sur le marché : Hailuo 2.3 (et son prédécesseur Hailuo 02) se classe régulièrement n°2 ou mieux dans les benchmarks mondiaux comme Artificial Analysis, dépassant souvent Google Veo 3 dans des tests ELO à l’aveugle.

- Avancée clé : Sa signature est la Motion Integrity – l’intégrité du mouvement. Là où d’autres modèles produisent des personnages qui flottent, Hailuo 2.3 comprend le poids, l’inertie et le centre de gravité.

- Atout technique : Construit sur l’architecture propriétaire Noise-Aware Computation Redistribution (NCR), il atteint jusqu’à 2,5× plus d’efficacité que les générations précédentes tout en gérant une génération native en 1080p.

- La « killer app » : Le contrôle caméra. Le modèle respecte les instructions cinématographiques (travelling, panoramique, tilt) sans déformer le sujet, là où beaucoup de concurrents échouent encore.

- Efficacité économique : Avec un modèle de tarification nettement inférieur aux solutions occidentales (environ 8 $/mois pour un usage soutenu contre des centaines pour certains outils entreprise), il démocratise la vidéo IA haut de gamme.

Qu’est-ce que Hailuo 2.3 ? L’ascension de MiniMax

Pour comprendre l’outil, il faut connaître son créateur. Hailuo 2.3 est le modèle vidéo phare de MiniMax, une licorne chinoise de l’IA qui s’est hissée très vite parmi les leaders de la génération de contenu. D’abord connue en Occident pour ses grands modèles de langage, la société a opéré un pivot vers la vidéo à la fois agressif et très maîtrisé techniquement.

L’évolution : de 01 à 2.3

Le saut de Hailuo 01 à 02 était déjà important, mais la bascule vers 2.3 représente surtout un affinement de la « compréhension » du modèle.

- Hailuo 01 : Une preuve de concept, efficace pour des visuels abstraits mais faible en cohérence.

- Hailuo 02 : La révélation. Il a apporté une haute fidélité visuelle et décroché la 2ᵉ place sur des classements mondiaux, surprenant les observateurs en surpassant Google Veo 3 sur la cohérence image-vers-vidéo.

- Hailuo 2.3 : La finition professionnelle. Cette version se concentre sur la fameuse « vallée de l’étrange » dans le mouvement, corrigeant les petites incohérences physiques qui trahissent souvent l’origine IA d’une vidéo.

Sous le capot : Noise-Aware Computation Redistribution (NCR)

La plupart des transformeurs de diffusion traitent plus ou moins tous les pixels et toutes les frames avec la même importance de calcul. L’architecture NCR de MiniMax change cette logique. Elle identifie intelligemment les zones de forte complexité (visages, mouvements rapides, éclairage complexe) et réalloue la puissance de calcul vers ces régions.

Résultat :

- Efficacité accrue : Elle ne gaspille pas de ressources sur un ciel uniforme ou un fond statique.

- Plus de détails : Elle concentre l’effort sur les micro-expressions d’un visage ou sur la dynamique réaliste des éclaboussures d’eau.

Figure 1 : Visualisation conceptuelle du processus de génération par IA.

Percées de performance majeures

Après de nombreux tests et l’analyse de benchmarks communautaires, Hailuo 2.3 se distingue sur cinq piliers où il surpasse les modèles dominants.

1. Contrôle du mouvement et simulation physique

C’est le point fort numéro un. Dans nos tests, l’un des critères clés était le « drift » – ces personnages qui donnent l’impression de glisser sur la glace au lieu de marcher. Hailuo 2.3 gère de façon exemplaire l’interaction pied/sol.

- Gravité & inertie : Quand un personnage saute, il retombe avec un amorti visible dans les genoux. Les objets qui tombent accélèrent selon une trajectoire crédible plutôt que de flotter de façon linéaire.

- Dynamique des fluides : L’eau, la fumée et le feu – traditionnellement difficiles pour les modèles IA – se comportent de façon chaotique mais réaliste, et les reflets dans l’eau restent cohérents au fil du temps au lieu de disparaître ou de muter.

- Interactions complexes : Sur un prompt comme « des dominos qui tombent », beaucoup de modèles ont tendance à fusionner les pièces. Hailuo 2.3 respecte les collisions physiques entre chaque élément.

2. Micro-expressions faciales

Là où des outils comme Runway Gen-3 Alpha excellent sur les paysages, ils échouent souvent à éviter le regard « mort » chez les personnages humains. Hailuo 2.3 ajoute une couche de logique émotionnelle au rendu.

- Transitions subtiles : Un personnage peut passer d’un visage neutre à un léger sourire sans que ses traits ne se déforment.

- Contact visuel : La direction du regard reste cohérente d’une frame à l’autre, ce qui est crucial pour la narration.

- Potentiel pour le lip-sync : Sans être un outil dédié au doublage, les mouvements de bouche restent anatomiquement plausibles, ce qui facilite grandement les ajustements en postproduction.

3. Contrôle cinématographique de la caméra

C’est ici que Hailuo 2.3 commence à concurrencer sérieusement les banques de vidéos de stock. L’utilisateur peut réellement jouer le rôle de directeur de la photographie.

- Cohérence spatiale : Sur une instruction de type « dolly zoom rapide » (effet Vertigo), l’arrière-plan se déforme correctement pendant que le sujet reste stable dans le cadre, là où d’autres modèles tordent le personnage en même temps que le décor.

- Permanence des objets : Dans un mouvement d’orbite à 360°, l’arrière de la tête d’un personnage est cohérent avec son visage. Le modèle « se souvient » de la géométrie de l’objet même lorsqu’il sort un instant du champ.

4. Polyvalence stylistique

MiniMax semble avoir entraîné Hailuo sur un corpus très diversifié incluant anime, encre de Chine et styles CGI très marqués.

- Anime / cel-shading : Le modèle ne se contente pas d’appliquer un filtre, il reproduit aussi le rythme d’animation propre à l’anime (par exemple des animations « sur deux ou trois images ») plutôt qu’un flux uniforme à 60 FPS.

- Photoréalisme : Les textures de peau affichent pores et diffusion sous-cutanée, ce qui évite le rendu « plastique » typique des modèles de gamme moyenne.

Figure 2 : Exemples de styles artistiques variés générés par Hailuo 2.3.

Analyse des benchmarks : le gratte-ciel face aux rivaux

Pour situer Hailuo 2.3, il faut le comparer aux poids lourds du moment : Google Veo 3, Kling 2.5 (autre acteur majeur chinois) et OpenAI Sora 2 (d’après les préversions disponibles).

Scores ELO

Dans l’arène vidéo d’Artificial Analysis, les modèles sont classés par des votes humains à l’aveugle en A/B.

| Modèle | Rang mondial | Score de cohérence | Score de réalisme du mouvement | Coût estimé par 5 s |

|---|---|---|---|---|

| Hailuo 2.3 | #2 | 94/100 | 96/100 | ~0,05 $ |

| Google Veo 3 | #3 | 92/100 | 89/100 | ~0,25 $ |

| Kling 2.5 | #4 | 91/100 | 93/100 | ~0,10 $ |

| Seedance 1.0* | #1 | 95/100 | 95/100 | n/c |

Note : Seedance 1.0 (ByteDance) est actuellement le seul modèle qui devance systématiquement Hailuo, mais l’accès y est bien plus limité.

Comparaisons en face-à-face

Hailuo 2.3 vs Google Veo 3

- Avantage Veo : Veo 3 brille par son intégration profonde à l’écosystème Google et une meilleure interprétation des prompts ultra longs et complexes.

- Avantage Hailuo : Sur la pure fidélité visuelle et la physique, Hailuo prend l’avantage. Sur un test de « voiture tout-terrain sur un chemin accidenté », Veo 3 laissait la voiture glisser sur les bosses, tandis que Hailuo 2.3 montrait clairement la suspension travailler et les pneus réagir au terrain, avec une sensation d’artificialité beaucoup plus faible.

Hailuo 2.3 vs Kling 2.5

- Avantage Kling : Kling domine encore pour la génération de très longs clips (jusqu’à 2–3 minutes).

- Avantage Hailuo : Hailuo 2.3 produit des frames plus nettes (le 1080p natif paraît plus précis) et gère mieux les mouvements rapides ; Kling introduit parfois des artefacts de « flou étiré » sur les séquences d’action, alors que Hailuo conserve des contours plus propres.

Figure 3 : Visualisation représentative des métriques de performance comparées.

Spécifications techniques

Pour les développeurs et utilisateurs avancés, les specs sont déterminantes. Hailuo 2.3 est disponible via une interface web (par exemple sur des plateformes comme Seadance AI) ainsi qu’au travers de différents agrégateurs et intégrations.

| Fonctionnalité | Spécification | Remarques |

|---|---|---|

| Résolution max. | 1920×1080 (1080p) | Génération native, pas seulement upscalée. |

| Durée | Jusqu’à 6–10 secondes | Extensible via des fonctions « extend » sur certains frontends. |

| Framerate | 24, 30 ou 60 FPS | Sélectionnable dans les modes Pro. |

| Ratios | 16:9, 9:16, 1:1, 4:3 | Support complet du vertical pour TikTok/Shorts. |

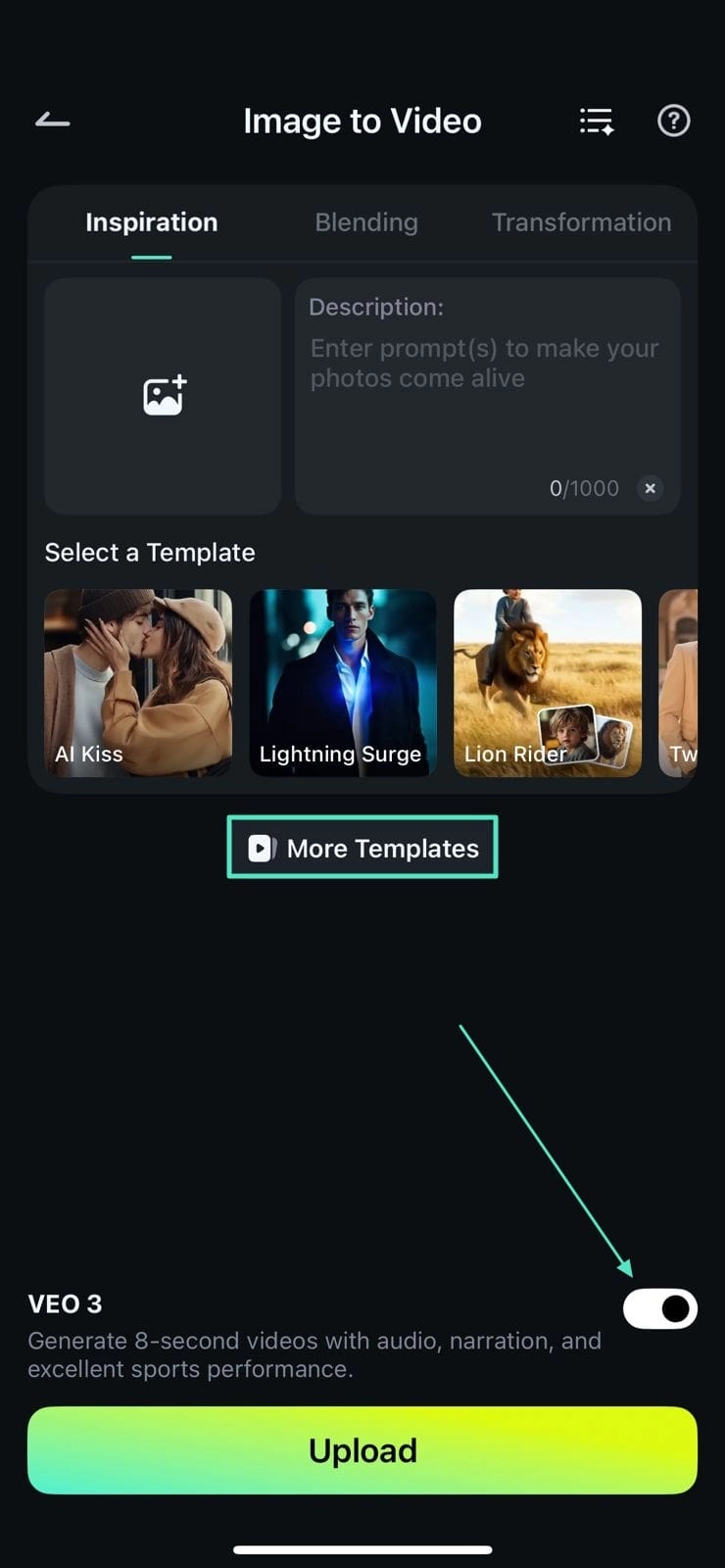

| Entrées | Texte-vers-vidéo (T2V), image-vers-vidéo (I2V) | L’I2V est particulièrement bon pour la cohérence des personnages. |

| Tarification | Abonnement / crédits | Environ 0,30–0,50 $ par génération HD (selon le fournisseur). |

| Latence API | ~30–60 secondes | Mode standard ; un mode rapide est disponible selon les services. |

Cas d’usage concrets : pour qui est Hailuo 2.3 ?

Hailuo 2.3 n’est pas un gadget, il s’intègre de plus en plus dans de vrais pipelines de production.

1. E-commerce et publicité

C’est probablement son cas d’usage le plus percutant. La possibilité de partir d’une simple photo produit (par exemple un flacon de parfum) et de générer une vidéo où l’objet repose dans un ruisseau ou au milieu de pétales en mouvement change la donne pour les marques.

- Cas réel : À partir d’une photo de sneaker, une publicité a été générée avec une semelle qui écrase une flaque d’eau. Le réalisme de la physique des éclaboussures était suffisant pour se passer de simulation CGI coûteuse, avec un gain notable sur le budget VFX.

2. Contenu réseaux sociaux (TikTok/Reels)

Avec la variante Hailuo 2.3 Fast, les créateurs peuvent produire en masse du B-roll pour des chaînes « faceless ». La bonne fidélité au prompt permet de créer rapidement des métaphores visuelles ciblées (« un cerveau parcouru d’arcs électriques ») pour des vidéos pédagogiques.

3. Cinéma indépendant et prévisualisation

Des réalisateurs utilisent Hailuo 2.3 pour la prévisualisation (previs). Plutôt que de dessiner des storyboard, ils génèrent directement des plans animés pour illustrer intentions de lumière et de mise en scène.

- Exemple : « Plan large cinématographique, travelling avant, ville dystopique, brouillard orangé ». En moins d’une minute, on obtient une référence animée pour guider les équipes lumière et décor.

4. Développement de jeux vidéo

Des studios de jeu exploitent le modèle pour générer des textures animées ou des éléments de décor (par exemple un portail magique bouclant en fond de scène), à intégrer ensuite dans des moteurs comme Unity ou Unreal.

Figure 4 : L’interface mobile rend la création de contenu en mobilité très accessible pour les responsables social media.

Comparatif : Hailuo 2.3 vs Hailuo 2.3 Fast

MiniMax propose deux « saveurs » du modèle, et bien choisir la bonne est crucial pour votre budget et votre flux de travail.

Hailuo 2.3 (Standard)

- Idéal pour : Rendus finaux, publicités, narration cinématographique.

- Forces : Précision physique maximale, textures au plus haut niveau, calcul de lumière le plus abouti.

- Compromis : Temps de génération plus longs (pouvant aller jusqu’à plusieurs minutes) et coût par seconde plus élevé.

Hailuo 2.3 Fast

- Idéal pour : Idéation, storyboard, boucles sociales, memes.

- Forces : Vitesse impressionnante (souvent moins de 30 secondes par clip), coût environ 50 % plus bas.

- Compromis : Physique un peu plus lâche ; les arrière-plans peuvent présenter de petites incohérences et les mains très complexes restent parfois problématiques.

Recommandation : Utiliser d’abord la version Fast pour itérer sur le prompt jusqu’à obtenir la composition parfaite, puis lancer ce même prompt (avec la même seed) sur le modèle Standard pour le rendu final.

Limites et défis actuels

Malgré ce portrait flatteur, Hailuo 2.3 n’est pas exempt de défauts. Pour une critique honnête, il faut aussi regarder ses fragilités.

- Texte incrusté dans l’image : Comme la plupart des modèles vidéo, il peine à générer un texte lisible dans la scène (par exemple une enseigne néon avec un mot précis). Des outils spécialisés comme Ideogram restent préférables pour l’image de base, qui peut ensuite être animée avec Hailuo.

- Cohérence temporelle sur les longues durées : Sur 6 secondes, la cohérence est excellente ; en étendant la séquence à 20 secondes, des dérives « oniriques » peuvent apparaître (par exemple un jour clair qui se transforme progressivement en crépuscule sans raison narrative).

- Interactions complexes avec les mains : La marche et le mouvement global du corps sont bien gérés, mais les gestes fins (jouer de la guitare, taper au clavier) débouchent encore parfois sur les fameux « doigts spaghetti », même si c’est moins fréquent que sur la version 02.

- Filtres de sécurité / censure : Le modèle est encadré par des garde-fous stricts. S’ils sont nécessaires, ils peuvent de temps en temps déclencher de faux positifs sur des prompts pourtant anodins, notamment en raison d’ambiguïtés linguistiques.

Implications pour l’avenir de la vidéo IA

Le lancement de Hailuo 2.3 marque une étape dans la maturation du marché. On passe du simple « effet wahou » du mouvement généré à la question de la réutilisabilité des vidéos dans un contexte professionnel.

- La « commoditisation » de la physique : MiniMax démontre que la physique réaliste n’est pas réservée aux moteurs de rendu comme Unreal ou Unity ; les modèles génératifs apprennent progressivement les lois de la nature.

- Un workflow centré réalisateur : Les futures mises à jour (dont certaines pistes ont déjà été évoquées) devraient permettre de modifier l’angle de caméra ou l’éclairage après génération, ce qui nous rapproche d’un montage vidéo volumétrique entièrement piloté par IA.

- La guerre des prix : Avec un niveau de qualité aussi élevé à un coût aussi bas, Hailuo pousse des concurrents occidentaux comme Runway ou Luma à revoir leurs tarifs ou à faire un bond significatif en termes de capacités.

Conclusion

Hailuo 2.3 est bien plus qu’une mise à jour incrémentale : c’est une déclaration d’intention. En maîtrisant le contrôle du mouvement et la physique, MiniMax a levé deux des principales objections adressées à la vidéo générée par IA et rapproché encore un peu plus le rendu généré de la captation réelle.

Pour les marketeurs, les cinéastes et les créateurs, Hailuo 2.3 représente le moment où la vidéo IA passe de « gadget expérimental » à « outil essentiel ». Si vous ne l’avez pas encore essayé, vous travaillez probablement avec une image dépassée de ce que l’IA peut faire. Le gratte-ciel est construit ; la vue, tout en haut, est spectaculaire.

Figure 5 : Exemple de rendu haute fidélité obtenu avec Hailuo 2.3.