Di recente sono finalmente riuscito a provare Hailuo 2.3, l’ultima iterazione del modello di generazione video di MiniMax e, per dirla in modo diretto, ha superato di gran lunga tutte le mie aspettative. In un panorama dominato dall’hype intorno a Sora e dal massiccio supporto aziendale dietro Veo di Google, Hailuo 2.3 sembra un gigante silenzioso che all’improvviso si alza in piedi e proietta la sua ombra su tutta la concorrenza.

Quando ho inserito il mio primo prompt – una scena complessa con una ballerina che si muove sotto una pioggia al neon, con istruzioni specifiche per il tracking della camera – mi aspettavo i soliti artefatti dei video IA: arti che si deformano, piedi che scivolano, sfondi che tremano. Invece ho ottenuto un livello di controllo del movimento e di aderenza alla fisica che dà davvero la sensazione di un salto generazionale.

Non si tratta di un semplice aggiornamento; è un cambio di prospettiva su quanto riteniamo “pronta” la video IA per i flussi di lavoro professionali. Ispirandosi alla cosiddetta “tecnica del grattacielo” – costruire sulle fondamenta dei modelli esistenti per creare qualcosa di molto più alto – questo articolo si pone come guida completa e definitiva a Hailuo 2.3. Andremo a smontarne l’architettura, a confrontarne le prestazioni con quelle dei giganti del settore e a vedere perché proprio questo modello potrebbe essere quello che finalmente colma il divario tra sperimentazione IA e produzione commerciale.

Executive Summary: il riassunto in 30 secondi

Per chi cerca solo il succo del discorso, ecco ciò che emerge dalla nostra analisi approfondita di Hailuo 2.3.

- Posizionamento di mercato: Hailuo 2.3 (insieme al suo predecessore Hailuo 02) si colloca stabilmente al 2° posto o più in alto in classifiche globali come Artificial Analysis, superando spesso Veo 3 di Google in test ELO alla cieca.

- Breakthrough principale: La caratteristica distintiva è la Motion Integrity, ovvero l’integrità del movimento. A differenza di molti concorrenti che generano personaggi “galleggianti”, Hailuo 2.3 “capisce” peso, slancio e centro di gravità.

- Vantaggio tecnico: Basato sulla architettura proprietaria Noise-Aware Computation Redistribution (NCR), raggiunge fino a 2,5 volte l’efficienza delle generazioni precedenti gestendo al tempo stesso una generazione nativa a 1080p.

- La “killer app”: Il controllo di camera. Il modello rispetta istruzioni cinematografiche (dolly, pan, tilt) senza deformare il soggetto, un punto critico in cui molti altri modelli falliscono.

- Efficienza dei costi: Con un modello di prezzo nettamente inferiore rispetto ai concorrenti occidentali (circa 8 dollari al mese per un uso intenso, contro centinaia per alcune soluzioni enterprise), rende accessibile la generazione di video di fascia alta.

Che cos’è Hailuo 2.3? L’ascesa di MiniMax

Per capire lo strumento, bisogna conoscere chi lo ha creato. Hailuo 2.3 è il modello video di punta di MiniMax, unicorno cinese dell’IA che è salito rapidamente ai vertici del panorama della generazione automatica. Sebbene in Occidente sia stata inizialmente conosciuta per i suoi modelli di linguaggio, la sua virata verso il video è stata aggressiva e tecnicamente molto ben calibrata.

L’evoluzione: da 01 a 2.3

Il balzo da Hailuo 01 a 02 è stato significativo, ma il passaggio alla versione 2.3 rappresenta soprattutto un raffinamento della “comprensione” del modello.

- Hailuo 01: Una prova di concetto, buona per visual astratti ma debole sul piano della coerenza.

- Hailuo 02: La rivelazione. Ha introdotto un’alta fedeltà visiva e ha raggiunto il 2° posto nelle classifiche globali, sorprendendo per avere superato Veo 3 di Google in termini di consistenza immagine‑video.

- Hailuo 2.3: La rifinitura professionale. Questa versione si concentra sulla “uncanny valley” del movimento, correggendo i piccoli errori di fisica che tradiscono immediatamente un video come generato dall’IA.

Sotto il cofano: Noise-Aware Computation Redistribution (NCR)

La maggior parte dei transformer di diffusione tratta ogni pixel e ogni frame in maniera grossomodo equivalente dal punto di vista computazionale. L’architettura NCR di MiniMax rompe questo schema. Identifica in modo intelligente le aree ad alta complessità (volti, movimenti rapidi, illuminazione complessa) e ridistribuisce la potenza di calcolo proprio su quelle zone.

Questo si traduce in:

- Maggiore efficienza: Non spreca risorse per un cielo statico o uno sfondo uniforme.

- Dettagli più ricchi: Incamera più capacità di calcolo sulle microespressioni del volto o sulle dinamiche di schizzi e spruzzi d’acqua.

Figura 1: Visualizzazione concettuale del processo di generazione video con IA.

Principali progressi prestazionali

Dopo test intensivi e l’analisi dei benchmark della community, Hailuo 2.3 mostra cinque pilastri in cui supera chiaramente i modelli concorrenti.

1. Controllo del movimento e simulazione fisica

Questa è la feature di punta. Nei test mi sono concentrato in particolare sul “drift”, ossia la sensazione di personaggi che scivolano sul pavimento anziché camminare. Hailuo 2.3 gestisce in modo eccellente l’interazione piede‑suolo.

- Gravità e slancio: Quando un personaggio salta, atterra assorbendo il peso con le ginocchia in modo realistico. Gli oggetti che cadono accelerano come in un mondo fisico credibile, invece di scendere con un movimento uniforme artificiale.

- Dinamica dei fluidi: Acqua, fumo e fuoco – storicamente ostici per i modelli IA – si comportano in modo caoticamente realistico. I riflessi nell’acqua rimangono coerenti nel tempo, invece di scomparire o deformarsi da un frame all’altro.

- Interazioni complesse: In un prompt tipo “tessere del domino che cadono”, i modelli precedenti tendono a fonderle fra loro. Hailuo 2.3 invece rispetta le collisioni fisiche fra le singole tessere.

2. Microespressioni facciali

Soluzioni come Runway Gen‑3 Alpha sono eccellenti nei paesaggi, ma spesso falliscono nel rendere lo sguardo “vivo” dei personaggi. Hailuo 2.3 integra uno strato di logica emotiva nella generazione dei volti.

- Transizioni sottili: Un personaggio può passare da un’espressione neutra a un lieve sorriso senza che il volto si deformi o si “sciolga”.

- Contatto visivo: La direzione dello sguardo rimane coerente, aspetto fondamentale per qualunque struttura narrativa.

- Potenziale per il lip-sync: Pur non essendo un modello specifico per la sincronizzazione labiale, i movimenti della bocca sono credibili dal punto di vista anatomico, rendendo più semplice il doppiaggio in post‑produzione.

3. Controllo cinematografico della camera

Qui Hailuo 2.3 inizia davvero a competere con i classici stock video. L’utente può praticamente comportarsi come un direttore della fotografia.

- Coerenza spaziale: Se si chiede un “dolly zoom veloce” (effetto Vertigo), lo sfondo si deforma nel modo giusto mentre il soggetto resta stabile, mentre molti altri modelli distorcono anche il personaggio.

- Permanenza degli oggetti: In un’orbita a 360°, il retro della testa del personaggio risulta coerente con il fronte; il modello “ricorda” la geometria dell’oggetto anche quando questo esce momentaneamente dall’inquadratura.

4. Versatilità stilistica

MiniMax sembra aver addestrato il modello su un dataset estremamente vario che include anime, pittura a inchiostro e diversi stili CGI molto caratteristici.

- Anime / cel‑shading: Non si limita a un filtro cartoon, ma riproduce anche il tipico ritmo a frame ridotti (ad esempio animazione “on twos” o “on threes”) al posto di un 60 FPS iperfluido e innaturale.

- Fotorealismo: Le texture della pelle mostrano pori e leggera traslucenza, evitando il classico effetto “plastica” dei modelli di fascia media.

Figura 2: Esempi di stili artistici differenti generati da Hailuo 2.3.

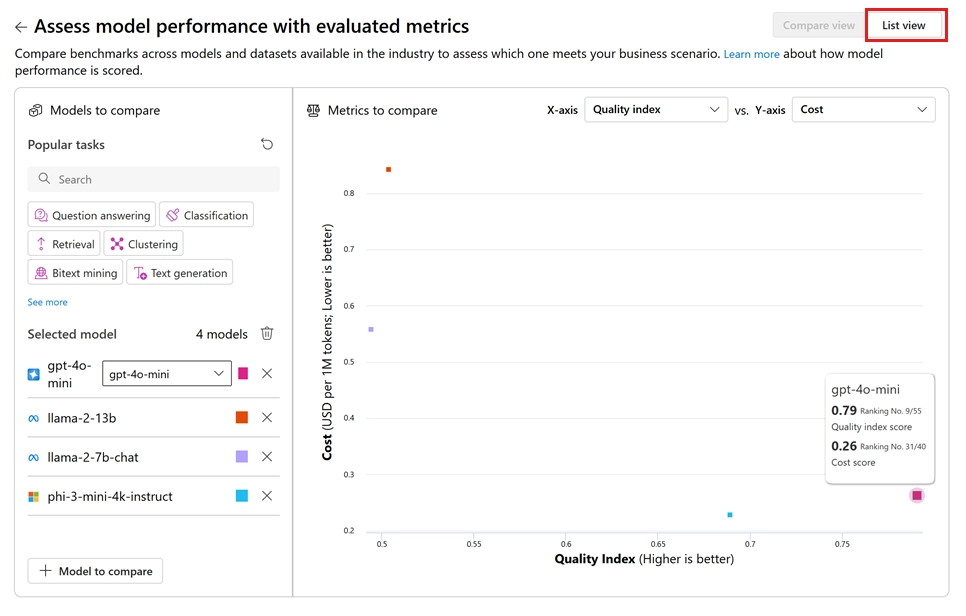

Analisi dei benchmark: il “grattacielo” tra i big

Per capire dove si colloca Hailuo 2.3, è utile confrontarlo con i tre grandi del momento: Veo 3 di Google, Kling 2.5 (altro colosso cinese) e Sora 2 di OpenAI (in base alle anteprime disponibili).

Punteggi ELO

Nell’Artificial Analysis Video Arena, i modelli vengono sottoposti a test A/B alla cieca e valutati dagli utenti.

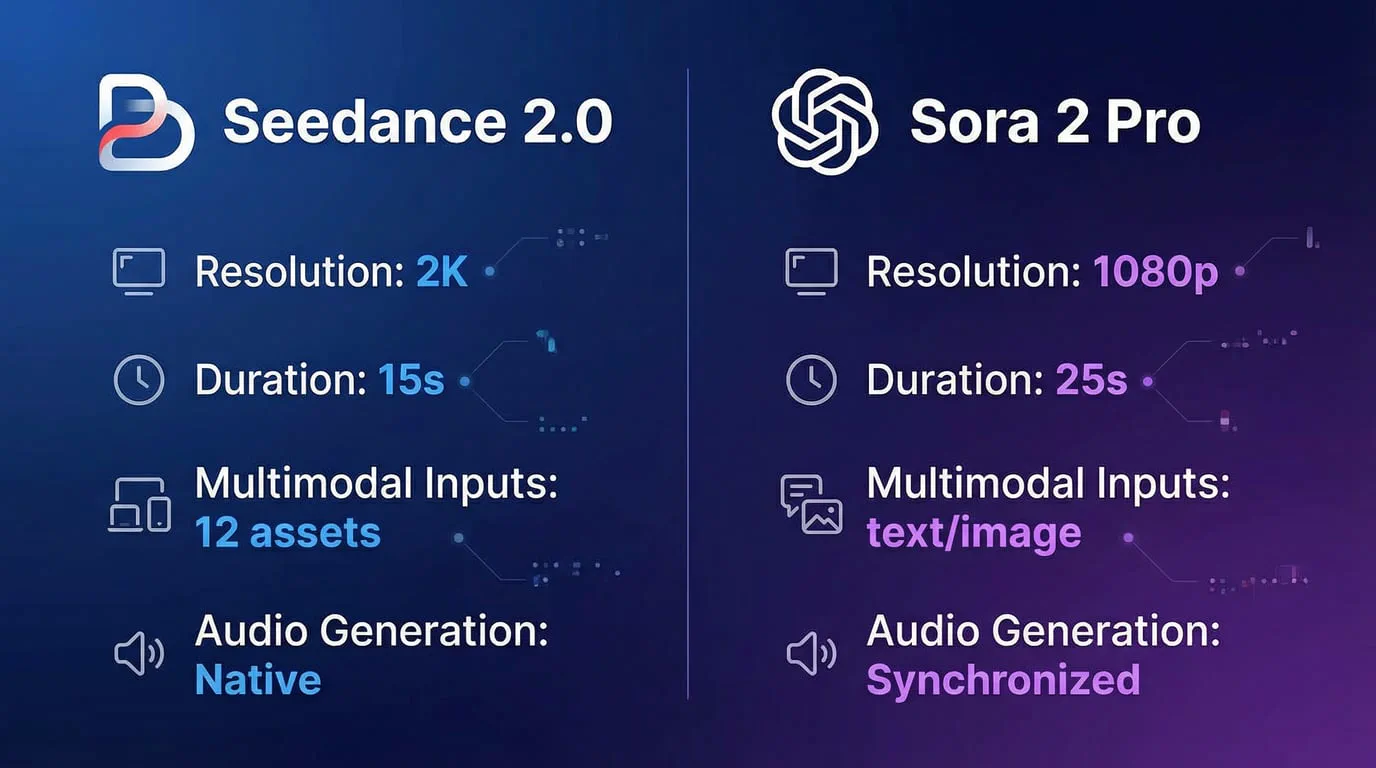

| Modello | Rank globale | Punteggio coerenza | Punteggio realismo movimento | Costo stimato per 5 s |

|---|---|---|---|---|

| Hailuo 2.3 | #2 | 94/100 | 96/100 | ~0,05 USD |

| Veo 3 (Google) | #3 | 92/100 | 89/100 | ~0,25 USD |

| Kling 2.5 | #4 | 91/100 | 93/100 | ~0,10 USD |

| Seedance 1.0* | #1 | 95/100 | 95/100 | n/d |

Nota: Seedance 1.0 (ByteDance) è attualmente l’unico modello che supera costantemente Hailuo, ma l’accesso è molto più limitato.

Confronti diretti

Hailuo 2.3 vs Veo 3

- Vantaggio di Veo: Veo 3 eccelle nell’integrazione con l’ecosistema Google e nella gestione di prompt testuali estremamente lunghi e complessi.

- Vantaggio di Hailuo: Su qualità visiva e fisica pura, Hailuo ha la meglio. In un test con “un’auto che guida in fuoristrada”, Veo 3 mostrava un’auto che scivolava sui dossi, mentre Hailuo 2.3 faceva vedere chiaramente la sospensione che lavora e le gomme che reagiscono al terreno, riducendo molto la sensazione di artificiosità.

Hailuo 2.3 vs Kling 2.5

- Vantaggio di Kling: Kling è stato il punto di riferimento per la generazione di clip lunghi, fino a 2–3 minuti.

- Vantaggio di Hailuo: Hailuo 2.3 produce frame più nitidi (il 1080p nativo risulta più “pulito”) e gestisce meglio i movimenti rapidi; Kling a volte introduce scie e artefatti di “smearing”, mentre Hailuo mantiene contorni e dettagli più definiti.

Figura 3: Rappresentazione grafica di alcune metriche prestazionali a confronto.

Specifiche tecniche

Per sviluppatori e power user, i dettagli tecnici fanno la differenza. Hailuo 2.3 è accessibile tramite interfaccia web (ad esempio su Seadance AI) e tramite numerose piattaforme terze.

| Caratteristica | Specifica | Note |

|---|---|---|

| Risoluzione massima | 1920×1080 (1080p) | Generazione nativa, non semplice upscaling. |

| Durata | Fino a 6–10 secondi | Estendibile tramite funzione “extend” su alcune UI. |

| Frame rate | 24, 30 o 60 FPS | Selezionabile in modalità Pro. |

| Formati | 16:9, 9:16, 1:1, 4:3 | Supporto completo per il formato verticale (TikTok/Shorts). |

| Input supportati | Testo‑video (T2V), Immagine‑video (I2V) | I2V è particolarmente forte nel mantenere la coerenza dei personaggi. |

| Modello di prezzo | Abbonamento / crediti | Circa 0,30–0,50 USD per generazione in HD (dipende dal provider). |

| Latenza API | ~30–60 secondi | Modalità standard; alcune piattaforme offrono modalità più rapide. |

Applicazioni reali: per chi è pensato Hailuo 2.3?

Hailuo 2.3 non è un giocattolo per smanettoni; sta entrando nei workflow di produzione reali.

1. E‑commerce e advertising

È forse il caso d’uso più forte. La possibilità di partire da una semplice foto di prodotto (per esempio un flacone di profumo) e generare un video in cui l’oggetto appare in un ruscello o circondato da petali che volteggiano è un game changer per i brand.

- Caso di studio: Da una foto di sneaker è stato generato uno spot in cui la scarpa calpesta una pozzanghera. La fisica degli schizzi era così credibile da rendere superflua una costosa simulazione CGI, con un risparmio notevole sul budget VFX.

2. Contenuti social (TikTok/Reels)

Con il modello Hailuo 2.3 Fast, i creator possono produrre enormi quantità di B‑roll per canali “faceless”. L’aderenza al prompt permette di creare metafore visive molto specifiche (come “un cervello che scintilla di elettricità”) per contenuti educativi o motivazionali in pochi secondi.

3. Cinema indipendente e pre‑visualizzazione

Registi e filmmaker indipendenti stanno iniziando a usare Hailuo 2.3 per la pre‑visualizzazione. Invece di disegnare storyboard, generano direttamente clip animati che trasmettono atmosfera e setup di luci.

- Esempio: “Wide shot cinematografico, dolly in, città distopica, foschia arancione.” Nel giro di un minuto, il regista ottiene una reference animata per guidare il reparto fotografia.

4. Sviluppo videogiochi

Gli sviluppatori di giochi usano il modello per creare texture animate o elementi di sfondo (ad esempio un portale magico in loop) da importare poi in engine come Unity o Unreal.

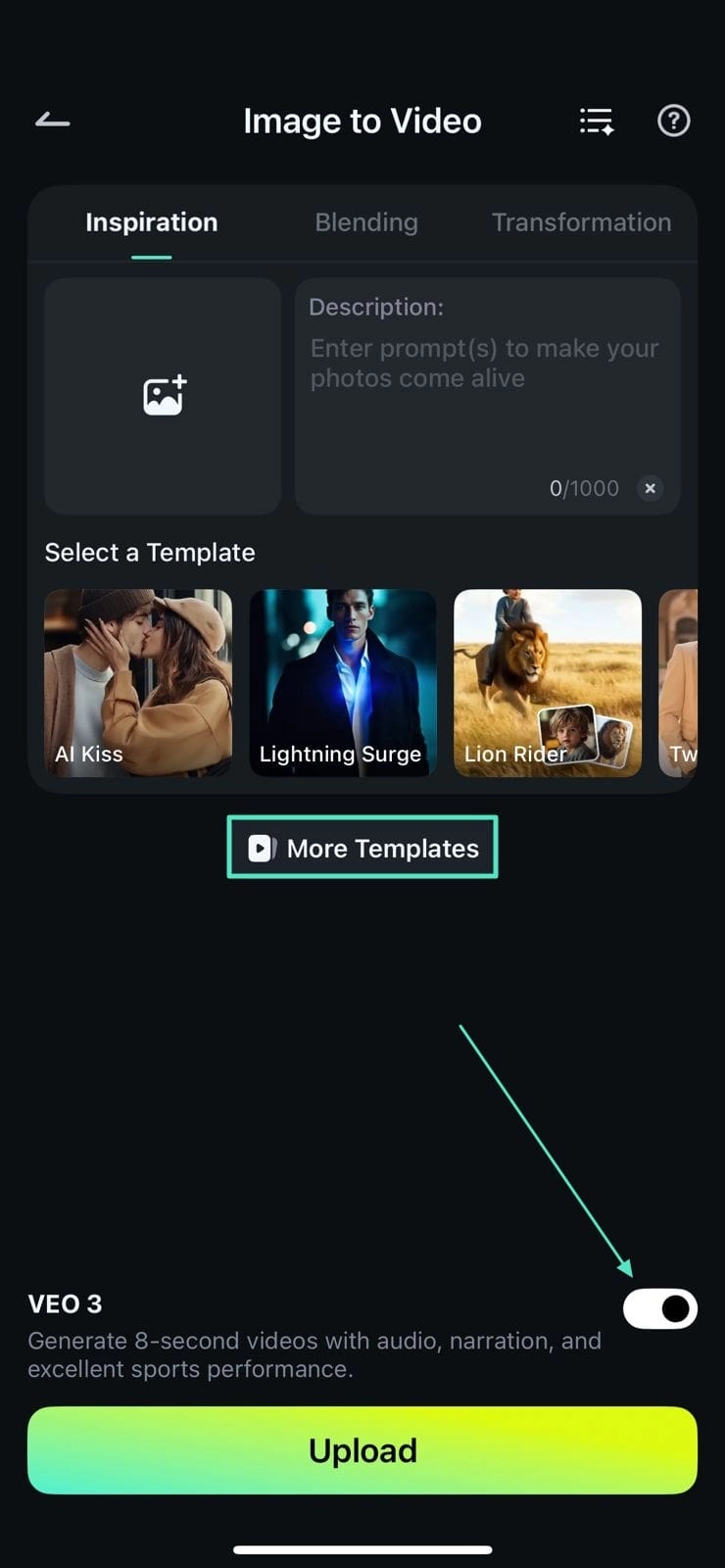

Figura 4: L’interfaccia mobile semplifica la creazione di contenuti on‑the‑go per social media manager e creator.

Confronto: Hailuo 2.3 vs Hailuo 2.3 Fast

MiniMax offre due varianti distinte del modello; scegliere quella giusta è fondamentale per ottimizzare budget e tempi.

Hailuo 2.3 (Standard)

- Ideale per: Output finale, spot pubblicitari, storytelling narrativo.

- Punti di forza: Massima accuratezza fisica, texture al livello più alto, calcoli di luce più raffinati.

- Compromessi: Tempi di generazione più lunghi (anche diversi minuti) e costo più elevato per secondo di video.

Hailuo 2.3 Fast

- Ideale per: Ideazione, storyboard, loop per i social, meme.

- Punti di forza: Velocità elevatissima (spesso sotto i 30 secondi per clip) e costo circa dimezzato.

- Compromessi: Fisica leggermente meno rigorosa; gli sfondi possono mostrare piccole incoerenze, e le mani in pose complesse ogni tanto presentano ancora difetti.

Consiglio pratico: Usa prima Fast per iterare sul prompt finché composizione e inquadratura non sono perfette. Poi, lancia lo stesso prompt (con lo stesso seed se possibile) su Standard per ottenere il render finale alla massima qualità.

Limiti e criticità

Nonostante il quadro molto positivo, Hailuo 2.3 non è privo di difetti. Per una valutazione equilibrata, è giusto evidenziare anche i punti deboli.

- Testo all’interno del video: Come la maggior parte dei modelli video, fatica a generare testi nitidi dentro la scena (ad esempio un’insegna al neon con una scritta specifica). Per questo tipo di contenuto restano spesso preferibili strumenti dedicati al text‑to‑image, da animare in un secondo momento.

- Coerenza temporale su durate più lunghe: Su clip di 6 secondi la coerenza è eccellente, ma estendendo a 15–20 secondi a volte compaiono transizioni “da sogno”, come il passaggio graduale da giorno a tramonto senza motivo narrativo.

- Interazioni complesse con le mani: La camminata e il movimento del corpo sono ormai credibili, ma azioni fini delle dita (suonare la chitarra, digitare sulla tastiera) possono ancora generare le famose “dita a spaghetti”, seppur con frequenza molto minore rispetto alla versione 02.

- Filtri di sicurezza / moderazione: Il modello è protetto da guardrail piuttosto rigidi. Sono necessari, ma talvolta possono bloccare prompt innocui se contengono termini ambigui o sensibili.

Implicazioni per il futuro della video IA

Il rilascio di Hailuo 2.3 indica che il mercato sta maturando. Ci stiamo spostando dal “wow, si muove!” alla domanda “questo video è davvero utilizzabile in produzione?”.

- La “commoditizzazione” della fisica: MiniMax dimostra che la fisica realistica non è più esclusiva dei motori come Unreal o Unity; i modelli generativi stanno iniziando a imparare le leggi della natura.

- Workflow sempre più regia‑centrico: È plausibile che gli aggiornamenti futuri permettano di cambiare luce o angolo di camera dopo la generazione, avvicinandoci a un editing video volumetrico interamente pilotato dall’IA.

- Guerra dei prezzi: Con questo mix di qualità alta e costi contenuti, Hailuo costringe competitor come Runway o Luma a ripensare modelli di pricing o a fare un salto deciso nelle capacità dei propri modelli.

Conclusione

Hailuo 2.3 è molto più di un semplice aggiornamento incrementale: è una dichiarazione di intenti. Grazie alla padronanza del controllo del movimento e della fisica, MiniMax affronta di petto due delle critiche principali rivolte al video generato da IA, avvicinando ancora di più il gap fra contenuto generato e riprese dal vivo.

Per marketer, filmmaker e creator, Hailuo 2.3 rappresenta il momento in cui il video IA passa da “esperimento” a “strumento imprescindibile”. Se non lo hai ancora provato, probabilmente ti stai basando su un’idea ormai superata di ciò che l’IA è in grado di fare oggi. Il grattacielo è stato costruito; e la vista dalla cima è davvero spettacolare.

Figura 5: Esempio di output ad alta fedeltà e ricco di dettagli generato con Hailuo 2.3.